Dans l’univers de l’IA, on a longtemps confondu aplomb et vérité. Les modèles répondaient à tout, tout le temps, quitte à inventer. Avec ChatGPT 5, OpenAI change de philosophie : le modèle peut désormais reconnaître ses angles morts et lâcher un simple « Je ne sais pas ». Pour certains, c’est anecdotique. En réalité, c’est peut-être l’évolution la plus importante depuis l’arrivée des IA grand public.

Ce qui s’est passé

Le 7 août 2025, OpenAI a officialisé GPT-5, nouvelle mouture de son moteur sous le capot de ChatGPT. Présenté comme un système « unifié », il adapte l’effort de raisonnement à la question posée ; parfois il va vite, parfois il “réfléchit” plus longtemps avant de répondre. Au cœur de cette mise à niveau : des progrès annoncés en code, en mathématiques, en rédaction, en santé et une meilleure gestion du contexte long.

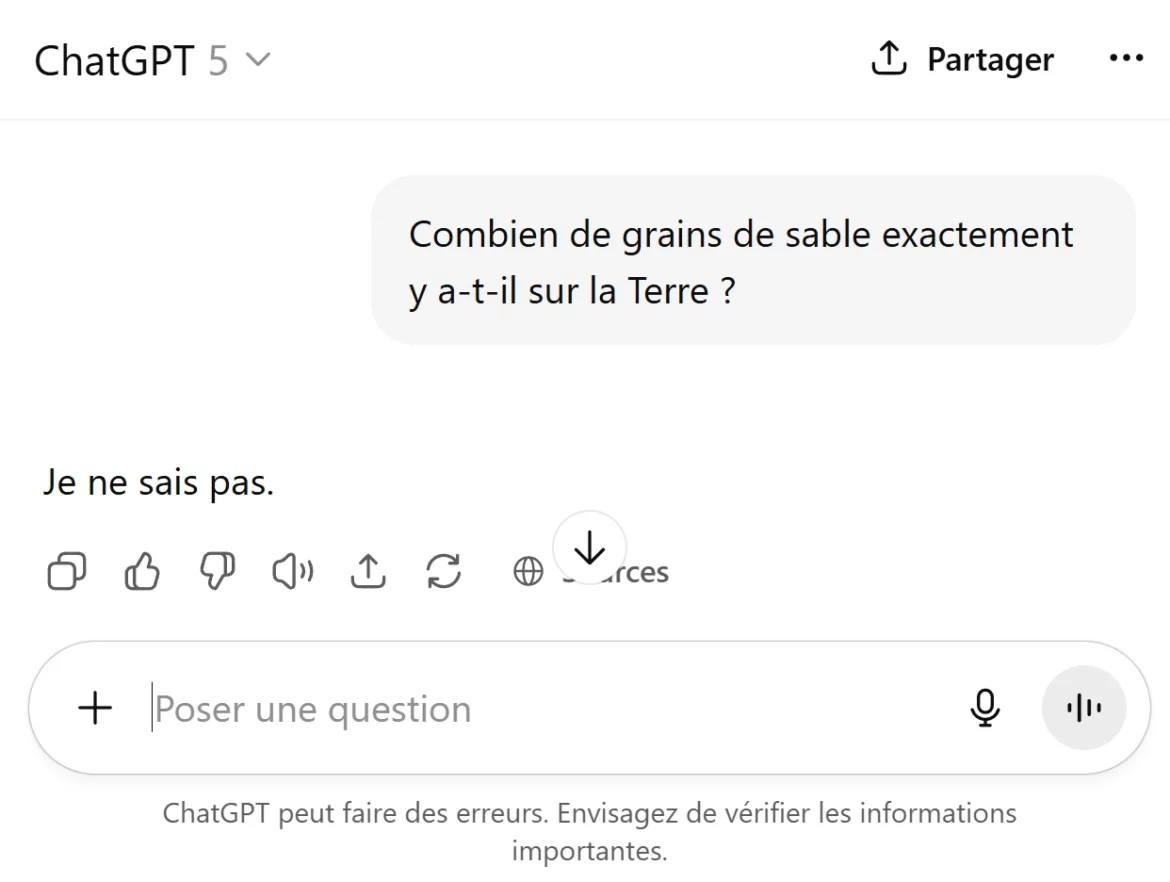

Mais la séquence qui a mis le feu aux poudres ne vient ni d’un benchmark, ni d’un labo. Elle tient dans une capture d’écran devenue virale : interrogé sur une question où l’information était introuvable, ChatGPT 5 a fini par conclure, après un temps de réflexion, « Je ne sais pas -> et je ne peux pas le savoir de manière fiable. » La scène a circulé sur X (Twitter) et a même reçu des applaudissements inattendus dans la tech. Bref, le bot qui admettait rarement l’incertitude… l’assume désormais au grand jour.

Pourquoi c’est une révolution dans le monde IA

On ne va pas se mentir : les « hallucinations » ont été la plaie des chatbots depuis leurs débuts. Ces réponses qui ressemblent à la vérité, mais qui n’en sont pas, ont entraîné des gaffes publiques, des démos embarrassantes et une défiance bien réelle. Admettre « je ne sais pas » n’est pas un aveu de faiblesse : c’est un garde-fou. C’est préférer une zone grise à une contre-vérité livrée avec aplomb.

Dans le jeu vidéo, ça parle d’autant plus : vous préférez un PNJ qui vous indique honnêtement que la quête n’existe pas… ou un PNJ qui vous envoie farmer trois heures un item imaginaire ? Sur le web, l’IA sûre d’elle mais factuellement à côté de la plaque, c’est exactement ça.

ChatGPT ne dira plus de rompre avec votre compagnon : OpenAI impose une nouvelle éthique à son IA

Comment GPT-5 y arrive « techniquement »

Sous le capot, OpenAI ne s’est pas contenté d’un « plus grand modèle ». GPT-5 introduit un entraînement orienté « safe-completion » : au lieu de répondre « non » trop vite (les fameuses “hard refusals”), le modèle est formé à rechercher la sortie la plus utile et la plus sûre. Quand la donnée est ambigüe ou indisponible, l’option « incertitude » devient une réponse normale et non un bug. Ajoutez à cela un mode de raisonnement prolongé ( celui qui affiche parfois une “réflexion” de plusieurs secondes ) et vous obtenez un modèle qui sait lever le pied plutôt que d’inventer.

L’accueil, lui, est contrasté. Une partie des utilisateurs salue la baisse des hallucinations et la montée en fiabilité sur les tâches complexes. D’autres regrettent un style jugé plus « corporate », moins “chaleureux” que certaines versions précédentes. Résultat : OpenAI maintient l’accès à d’anciens modèles pour rassurer les habitués, tandis que la presse spécialisée parle d’un lancement solide mais moins “révolutionnaire” que promis. Pour le grand public, c’est déroutant ; pour les power-users, c’est une bonne nouvelle : la transparence progresse, l’outil se spécialise.

« Je ne sais pas » : bug, fonctionnalité… ou prise de conscience?

Là où la phrase peut choquer (« Comment ça, tu ne sais pas ? »), elle marque au contraire une maturité bienvenue. Dans un monde saturé d’info, reconnaître l’absence de source fiable, c’est rendre service à l’utilisateur. Pour la rédaction de Kingofgeek, c’est tout l’enjeu : mieux vaut un “no contest” qu’un headshot dans le vide.

Et non, cela ne rend pas l’IA “faible”. Au contraire : apprendre à douter, c’est apprendre à mieux répondre. Sur des sujets sensibles (santé, finance, sécurité), ce mécanisme réduit la tentation du remplissage hasardeux. Au quotidien, cela force aussi chaque service à se reposer sur de la vraie vérification : navigation web lorsqu’elle est disponible, citations, ou renvoi vers des bases de connaissances fiables.

Concret pour les joueurs, créateurs et moddeurs

- Guides & soluce. Quand un boss fraîchement patché change d’IA ou qu’un drop rate est encore non documenté, GPT-5 peut choisir l’honnêteté : « donnée insuffisante ». Moins sexy qu’une soluce mensongère, mais diablement utile pour éviter de farmer pour rien.

- Builds & theorycraft. Les meilleures configs sont mouvantes. Mieux vaut un modèle qui signale l’incertitude plutôt qu’un “meta” fantasmé basé sur un post de forum périmé.

- Modding & code. En script, GPT-5 brille sur la génération et le debug. Et quand l’environnement du mod est trop exotique, le modèle peut vous orienter vers les docs plutôt que bricoler une réponse cassée. (Le fameux « je ne sais pas » est souvent suivi d’une piste de recherche — c’est tout l’intérêt.)

- Création de contenu. Pour les streamers et rédacteurs, cela évite de propager des rumeurs. Dans l’économie de l’attention, ne pas raconter n’importe quoi est un super-pouvoir.

Les limites à avoir en tête

Évidemment, tout n’est pas rose. Si l’IA se met à douter trop souvent, l’expérience devient frustrante. Le calibrage est donc crucial : savoir quand chercher plus longtemps, quand dire stop et quand proposer des alternatives. De plus, « je ne sais pas » ne doit pas devenir un refuge par défaut pour éviter de travailler. Dans la pratique, GPT-5 a encore des ratés (sur-refus, lenteurs ponctuelles, tonalité jugée trop neutre), mais les correctifs avancent vite. L’important : on n’achète plus une promesse d’infaillibilité, on adopte un compagnon de recherche plus honnête.

Et maintenant ?

Si vous êtes du genre à tester toutes les nouveautés day one, vous verrez la différence surtout quand l’info manque ou quand la question touche une zone sensible. GPT-5 choisira plus volontiers la prudence. Ce n’est pas le gadget du siècle, c’est de l’ergonomie cognitive : une IA qui vous garde loin des embuscades. Dans le jeu vidéo comme ailleurs, c’est souvent ça, la victoire : éviter le wipe.

Verdict du Geek : L’IA qui sait dire « je ne sais pas », c’est l’IA qui commence à mériter votre confiance. On signe où ?