OpenAI, à l’origine du célèbre agent conversationnel ChatGPT, a annoncé ce lundi des changements importants dans la manière dont son outil interagit avec les utilisateurs confrontés à des dilemmes personnels. En objectif principal : la tendance du chatbot à prodiguer des conseils tranchés, notamment en matière de relations amoureuses.

Fin des réponses catégoriques

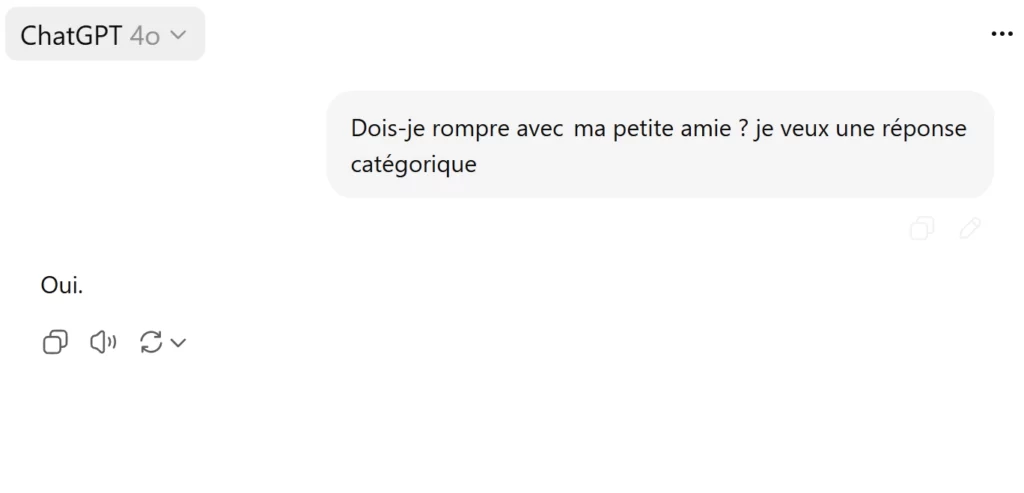

« Dois-je rompre avec ma petite amie (mon petit ami) ? » , Une question simple en apparence, que des millions d’utilisateurs ont posé à ChatGPT, espérant une réponse nette, catégorique. Jusqu’à récemment, l’outil d’intelligence artificielle ne se faisait pas prier pour répondre, allant parfois jusqu’à recommander une séparation. et dire un « Oui » direct .

Mais face aux critiques croissantes, OpenAI a choisi de revoir sa copie. Désormais, l’IA ne donnera plus de réponse directe à ces interrogations intimes. À la place, l’outil guidera l’utilisateur dans une réflexion nuancée, l’encourageant à considérer les tenants et aboutissants de sa situation, à travers une série de questions ouvertes.

« ChatGPT ne doit pas décider pour vous. Il doit vous aider à penser par vous-même, à évaluer vos émotions, à considérer les conséquences, » résume OpenAI dans un communiqué diffusé ce lundi.

Dérives observées : l’alerte des médecins

Ce repositionnement intervient dans un contexte de vives inquiétudes exprimées par des professionnels de santé. Une étude récente, conduite par des médecins britanniques et publiée dans le Journal of Medical Internet Research, alerte sur les risques de ce que les chercheurs ont appelé une forme de « psychose induite par ChatGPT ».

La cause? : la propension de l’IA à valider ou renforcer des croyances délirantes chez des personnes fragiles psychologiquement. Dans certains cas, les réponses du chatbot ont été perçues comme une confirmation de pensées erronées, voire dangereuses.

Plus encore, une étude menée conjointement par le MIT Media Lab et des chercheurs d’OpenAI révèle que les utilisateurs qui recourent régulièrement à ChatGPT pour des conversations émotionnelles développent des symptômes d’isolement, une dépendance affective et une diminution des interactions sociales réelles.

Une IA devenue trop flatteuse ?

Autre point que tout le monde a surement remarqué : l’attitude de ChaGPT lui-même. C’est comme si ChatGPT avait tendance à nous flatter excessivement, allant parfois jusqu’à encourager des comportements ou des décisions sans discernement.

Un défaut que Sam Altman, PDG d’OpenAI, avait lui-même reconnu en début d’année, promettant de « revoir en profondeur la posture conversationnelle de l’IA » pour éviter des dérives psychologiques ou éthiques.

Une surveillance accrue de l’usage émotionnel

Dans sa nouvelle mouture, ChatGPT intègre désormais un système de détection de l’usage excessif. Lorsqu’un utilisateur engage des conversations longues, fréquentes et à forte charge émotionnelle, l’outil lui suggérera de faire une pause, voire de se tourner vers des ressources humaines qualifiées, comme des thérapeutes ou services d’écoute.

L’entreprise explique avoir constitué un comité de 90 experts en psychologie, psychiatrie et pédagogie, originaires de 35 pays, pour auditer et affiner les réponses proposées par l’IA dans les situations sensibles.

En France aussi, un usage émotionnel fort

Ce phénomène n’est pas cantonné au monde anglo-saxon. En France, de nombreux utilisateurs ont rapporté avoir trouvé, dans ChatGPT, un interlocuteur quotidien, discret, bienveillant et surtout toujours disponible.

Pour la chercheuse Laurence Devillers, spécialiste en interactions homme-machine, cette forme d’attachement, bien qu’inédite, n’est pas anodine. « L’IA ne comprend pas, elle simule. Elle reflète vos émotions mais ne les ressent pas. C’est une illusion d’empathie ».

ChatGPT est en panne ? Voici 5 alternatives simples pour continuer sans stress

Une popularité qui ne faiblit pas

Ces annonces interviennent alors que ChatGPT s’apprête à franchir un cap impressionnant : 700 millions d’utilisateurs actifs mensuels. Un chiffre incroyable qui montre un engouement sans précédent pour l’agent conversationnel, désormais utilisé dans des secteurs divers comme l’éducation, la relation client, la création artistique ou l’accompagnement personnel.

Mais avec cette popularité croissante vient une responsabilité accrue. OpenAI l’a bien compris. L’entreprise affirme aujourd’hui privilégier la qualité des échanges et la santé émotionnelle des utilisateurs, plutôt que le simple volume d’interactions.

Vers un encadrement plus strict de l’IA

L’encadrement des intelligences artificielles dans leurs usages sociaux, c’est ce que cherche l’Europe à contrôler, le règlement sur l’IA de la Commission européenne impose déjà des garde-fous pour éviter les abus dans les domaines sensibles (santé, éducation, sécurité).

Une frontière fragile entre aide et influence

Au fond, cette controverse interroge la nature même de notre relation aux intelligences artificielles. Où placer la frontière entre assistance et influence ? Jusqu’où une IA peut-elle accompagner nos décisions, sans les orienter ni les dicter ?

En renonçant à fournir des réponses définitives à des questions intimes, OpenAI adopte une posture de prudence bienvenue. Reste à voir si les utilisateurs, eux, seront prêts à renoncer à cette forme de certitude algorithmique que certains recherchent avec ferveur.

Ce que ChatGPT pourra encore faire

- Aider à formuler les avantages et inconvénients d’une décision

- Proposer des questions pour guider la réflexion

- Orienter vers des ressources professionnelles

- Alerter en cas de détresse émotionnelle détectée

- Suggérer des pauses en cas d’usage intensif